科技日報記者 王春

從一句話生成一張圖,到幾秒鐘生成一段視頻,生成式人工智能正在走向更復雜的真實世界應用。模型越大、分辨率越高、生成內容越豐富,對算力與能耗的需求就越驚人,后摩爾定律時代,面向未來的研究焦點轉向光電計算等“下一代算力芯片”。如何讓下一代算力光芯片能運行復雜生成模型,成為全球智能計算領域公認的難題。

上海交通大學集成電路學院陳一彤課題組在新一代算力光芯片方向取得重大突破,首次實現了支持大規模語義視覺生成模型的全光計算芯片LightGen。相關研究成果發表于最新一期國際學術期刊《科學》。

專家解釋,所謂“光計算”,可以通俗理解為不是讓電子在晶體管中運行,而是讓光在芯片中傳播,用光場的變化完成計算。光天然具備高速和并行的優勢,因此長期被視為突破算力與能耗瓶頸的重要方向。然而,要把光計算真正用到生成式AI上,并非這么簡單:生成模型往往規模更大,還需要在不同維度之間不斷變換;如果芯片規模較小,則不得不頻繁在光與電之間級聯或復用,速度優勢會被延遲和能耗迅速抵消。因此,全光計算,就顯得更為重要和困難。

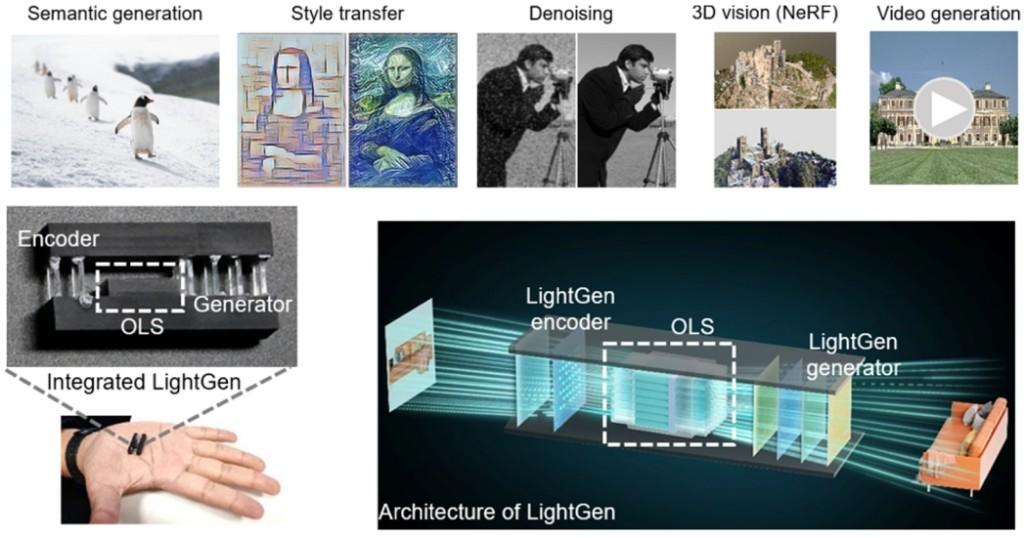

LightGen之所以能夠實現驚人的性能飛躍,在于它在單枚芯片上同時突破了三項領域公認的關鍵瓶頸:單片上百萬級光學神經元集成、全光維度轉換,不依賴真值的光學生成模型訓練算法。這三項中的任意一項單獨突破都足以構成重要進展,而LightGen將它們同時實現,使得面向大規模生成任務的全光端到端實現成為可能。

更重要的是,LightGen展示的并不是電輔助光做生成,而是讓全光芯片完整實現“輸入—理解—語義操控—生成”的閉環:輸入圖像進入芯片后,系統能夠提取與表征語義信息,并在語義操控下生成全新的媒體數據,實現讓光“理解”和“認知”語義。論文實驗驗證,LightGen可完成高分辨率(≥512×512)圖像語義生成、3D生成(NeRF)、高清視頻生成及語義調控,同時支持去噪、局部與全局特征遷移等多項大規模生成式任務。

在性能評估上,LightGen采用了極嚴格的算力評價標準:在實現與電芯片上運行的Stable Diffusion、NeRF、Style Injection Diffusion等前沿電子神經網絡相仿生成質量的前提下,直接對端到端耗時與耗能進行測量。實測表明,即便采用較滯后性能的輸入設備,LightGen仍可取得相比頂尖數字芯片2個和2個數量級的算力和能效提升。而如果采用前沿設備使得信號輸入頻率不是瓶頸的情況下,LightGen理論可實現算力提升7個數量級、能效提升8個數量級的性能躍升。這不僅體現了在不犧牲生成效果的情況下,用全光方案替換現有方案可能帶來的巨大增益,也從側面印證了大規模集成、全光維度變換與無真值訓練等難點被系統性解決后,全光片上承載大規模生成網絡的現實意義。

該文也同步被《科學》官方選為高光論文重點報道。文中提到,生成式AI正加速融入生產生活,要讓“下一代算力芯片”在現代人工智能社會中真正實用,勢在必行的是研發能夠直接執行真實世界所需前沿任務的芯片——尤其是大規模生成模型這類對端到端時延與能耗極高的任務。面向這一目標,LightGen為新一代算力芯片真正助力前沿人工智能開辟了新路徑,也為探索更高速、更高能效的生成式智能計算提供了新的研究方向。

(受訪對象供圖)

網友評論

網友評論